Gemma é uma coleção de modelos abertos leves e modernos construídos pelo Google. Eles foram projetados para executar rapidamente em dispositivos como telefones, em máquinas na nuvem, para ajudar os desenvolvedores a criar aplicativos de IA. Neste post, você aprenderá a maneira mais fácil e rápida de executar a versão mais recente de Gemma, 3 (4 b), no Google Cloud Run implantado no Google AI Studio. Vamos começar!

Índice #

Gemma 3 na nuvem Run #

Para implantar Gemma 3 (modelo de 4 bilhões de parâmetros) no Google Cloud Run do Google AI Studio. Tamanho dos modelos Gemma 3 intervalos De 815 Mb para parâmetros 1b a 17 GB para os parâmetros de 27b. O modelo que você implantará são os parâmetros 4B, que são 3,3 GB.

Você primeiro criará um novo projeto do Google Cloud. Você pode implantar o Gemma 3 do AI Studio com apenas alguns cliques. Quando implantado no AI Studio, ele usa Ollama sob o capô para executar o Gemma 3 dentro de um recipiente. Nesse contêiner, há um servidor/proxy slim go verificar a chave da API.

Você também aprenderá sobre um comando que poderá executar no Google Cloud Shell que terá um efeito semelhante posteriormente neste tutorial. Você criará um novo projeto do Google Cloud na próxima seção para continuar.

Crie o Google Cloud Project #

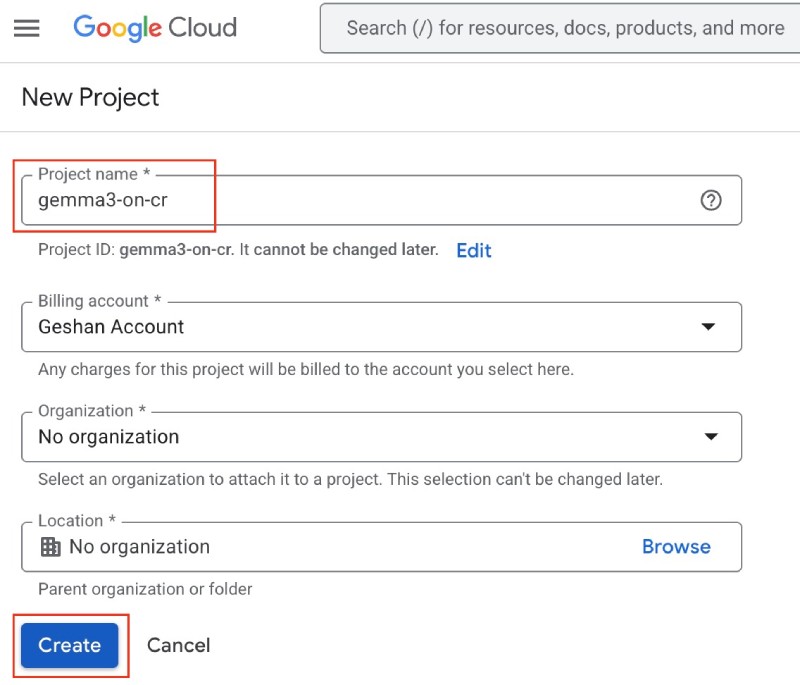

Para criar um novo projeto do Google Cloud, verifique se você está conectado à sua conta do Google. Então você pode ir para o Crie um novo projeto Página no GCP e preencha os seguintes detalhes:

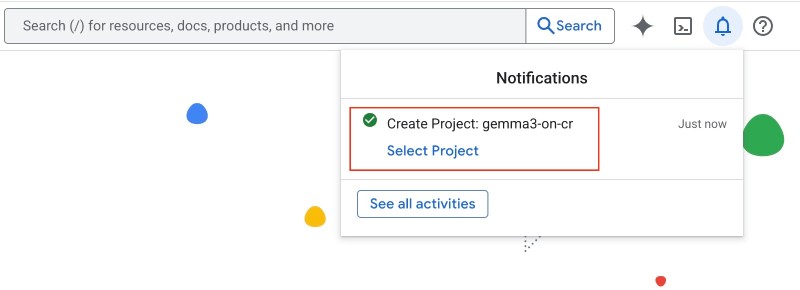

Depois disso, clique no Create Botão azul para criar o projeto. Pode levar algum tempo, e seu projeto será criado, e você será notificado sobre isso:

Observe o nome do projeto que você acabou de criar. Em seguida, vá para o Google AI Studio e siga as etapas mostradas na próxima seção.

Implante Gemma 3 do AI Studio #

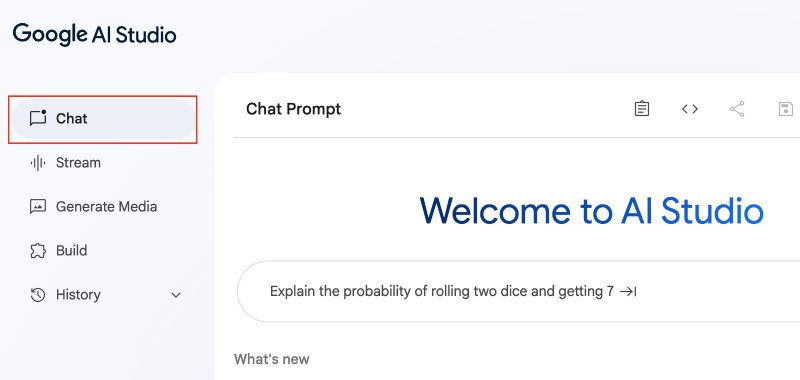

Sobre Google AI Studiová para o Chat Seção, que deve abrir por padrão:

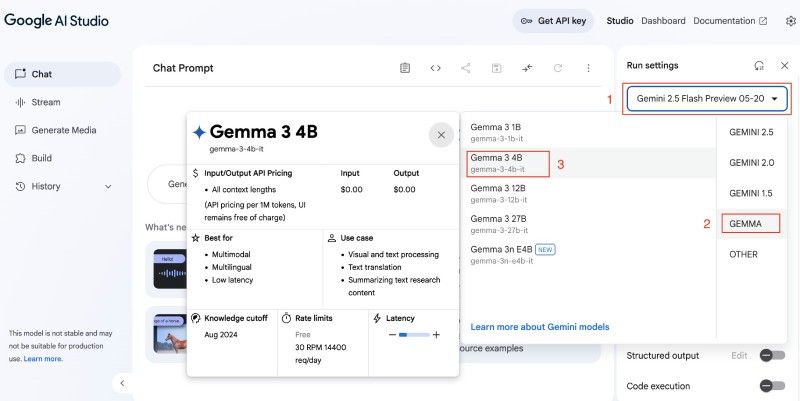

Sob o Run setting Na barra do lado direito, clique no menu suspenso que possui o nome do modelo selecionado, como Gemini 2.5 Flash…então selecione Gemmae depois disso clique Gemma 3 4Bcomo visto abaixo:

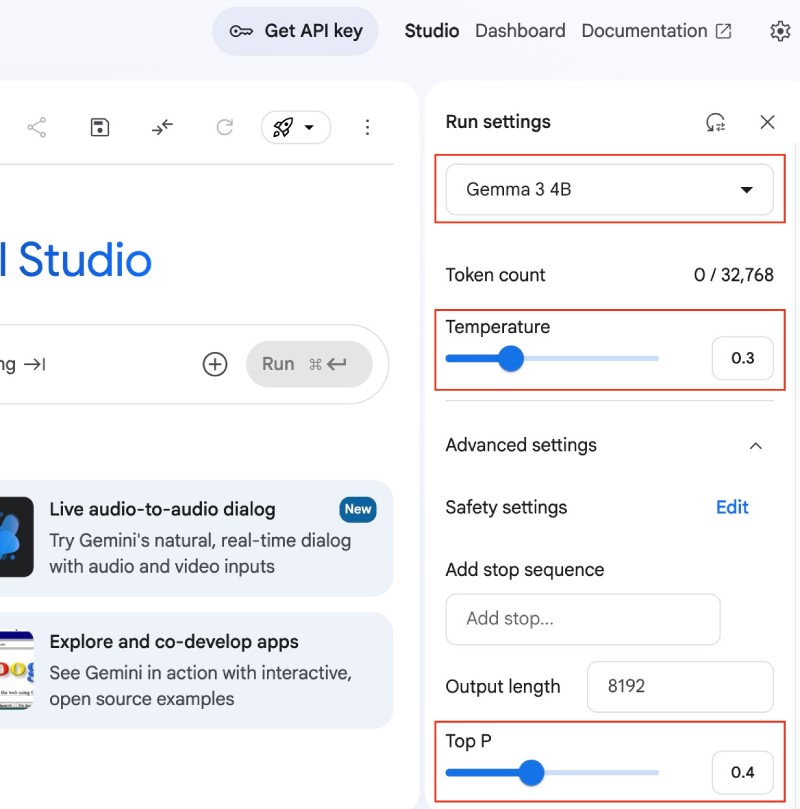

No selecionado Gemma 3 4B modelo, reduza a temperatura para 0.3 e a melhor configuração de P para 0.4 do seguinte modo:

A configuração acima não importa quando você implanta. Se quiser, você pode conversar com Gemma 3, como pergunte why is the sky blue?, give the shortest possible answer. Deve devolver uma resposta de uma frase.

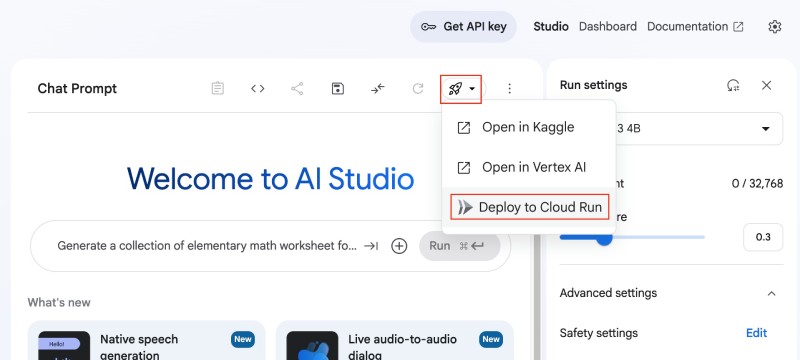

Depois disso, clique no ícone de foguete em preto e branco (🚀) além do Run settings e clique Deploy to Cloud Run Como visto abaixo:

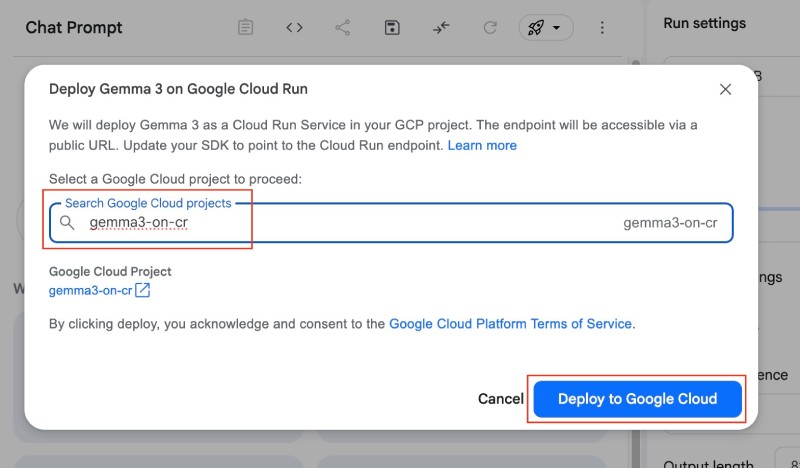

Em seguida, você pode selecionar o projeto criado na etapa anterior, que foi gemma3-on-cr No meu caso:

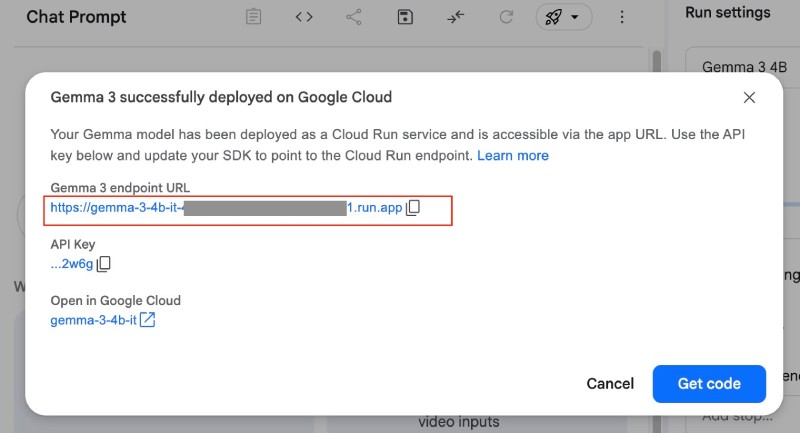

Depois disso, clique no Deploy to Google Cloud botão azul. Levará algum tempo para dizer Deploying to Cloud Run. Se tudo correr bem depois de alguns minutos, você receberá um URL onde Gemma 3 (4B) está sendo executado no Google Cloud Run com uma chave da API da seguinte forma:

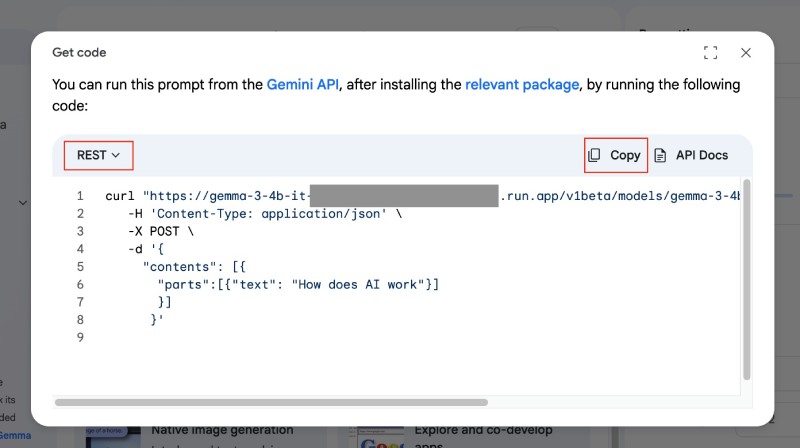

Você pode clicar no Get code Botão azul para experimentar um comando curl para verificar se Gemma 3 na nuvem Run funciona conforme o esperado, selecione REST À esquerda, selecione a caixa e copie o código:

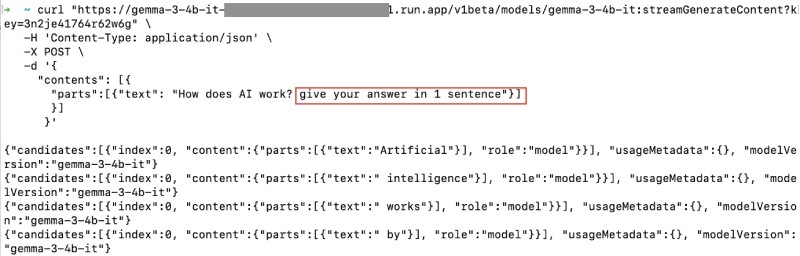

Quando você executa o código copiado na linha de comando, adicione give your answer in 1 sentenceentão execute apenas o código. O código final que eu executei foi:

curl "https://gemma-3-4b-it-some-long-number-region.run.app/v1beta/models/gemma-3-4b-it:streamGenerateContent?key=the-api-key" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[{"text": "How does AI work? give your answer in 1 sentence"}]

}]

}'Que resultou em:

Hurra! Você tem Gemma 3 em execução no Google Cloud Run. Agora você pode usá -lo em seus aplicativos. Você pode adicionar Abra Webui Se você gosta.

A imagem do docker #

Da superfície, parece parcialmente como mágica, mas a maior parte do levantamento pesado está sendo feito por uma imagem do Docker pré -construída disponível no Google Cloud Artifact Registry (PKG.DEV) construído com o Google Cloud Biuld.

Quando você lê os documentos oficiais sobre Gemma na nuvem Runvocê pode descobrir que existem imagens de docker pré-criadas como Gemma 3: 4b no registro do pacote. Como GPUs no Cloud Run Tornou -se disponível sob demanda, sem necessidade de reservas, a implantação de qualquer modelo com Ollama no Cloud Run se tornou muito mais fácil.

O Dockerfile também tem um servidor proxy Para adicionar a validação da chave da API no topo de uma instância regular do ollama. Seria bom passar pelo Readme Para saber mais sobre isso e outros recursos.

Na próxima seção, você aprenderá sobre o comando único para implantar o Gemma 3 na nuvem.

Como executá -lo com um comando #

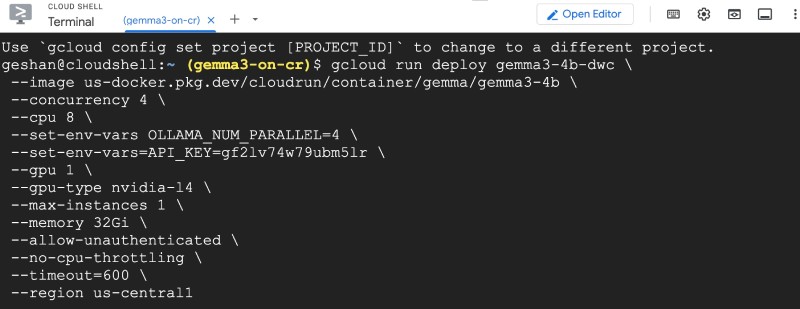

Para executar Gemma 3: 4b na nuvem Run, você pode executar o seguinte comando em Shell do Google Cloud do seu respectivo projeto do Google Cloud:

gcloud run deploy gemma3-4b-dwc \

--image us-docker.pkg.dev/cloudrun/container/gemma/gemma3-4b \

--concurrency 4 \

--cpu 8 \

--set-env-vars OLLAMA_NUM_PARALLEL=4 \

--set-env-vars=API_KEY=gf2lv74w79ubm5lr \

--gpu 1 \

--gpu-type nvidia-l4 \

--max-instances 1 \

--memory 32Gi \

--allow-unauthenticated \

--no-cpu-throttling \

--timeout=600 \

--region us-central1Você pode executá -lo no Google Cloud Shell como:

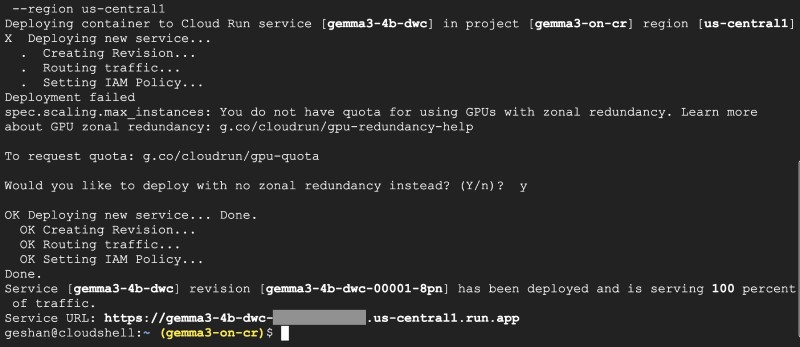

Pode pedir que você implante com no zonal redundancyescrever y Para sim, e deve implantar o serviço e devolver um URL da seguinte forma:

Se você atingir a chave URL com a chave da API, poderá ver o Ollama is running mensagem como visto abaixo:

Aí está. Agora você sabe que decodificou o segredo do Magic AI Studio em segundo plano para permitir a chave da API. O Gemma 3 está em execução no Google Cloud Run com o Ollama e um servidor proxy escrito em Go.

Conclusão #

Nesta postagem, você aprendeu sobre a implantação da Gemma 3 no Google Cloud Exclive na interface intuitiva do Google AI Studio, que simplifica um processo complexo em alguns cliques. Você também aprendeu que essa implantação aproveita a Ollama e as imagens pré-construídas do Docker do Registro de Artefatos do Google Cloud, aprimorado com um servidor proxy baseado em GO para validação de chave da API.

Além disso, você pode decodificar a mágica usando um único comando gcloud no Google Cloud Shell, oferecendo flexibilidade e controle sobre parâmetros de implantação como concorrência, CPU, GPU e memória. Ambos os métodos resultam em uma instância funcional do Gemma 3 na nuvem, pronta para ser integrada aos aplicativos, fornecendo a desenvolvedores como você com poderosos recursos de modelo de AI com um esforço mínimo. Continue experimentando!